L’IA et le défi de l’explicabilité

Dans le paysage en constante évolution de l‘Intelligence Artificielle (IA), l’explicabilité émerge comme un critère incontournable pour les entreprises. Souvent désignée sous le terme de XAI pour « Explainable Artificial Intelligence« , l’explicabilité en IA est devenue une nécessité plutôt qu’un luxe. Cet article, destiné aux décideurs de la relation client, explore en profondeur pourquoi l’explicabilité est cruciale, comment elle influence l’éthique et la réglementation, et en quoi elle est indispensable pour une IA de confiance. Nous aborderons également les risques associés à l’IA et les différents types d’IA, ainsi que la responsabilité liée aux décisions prises par ces dernières.

Qu’est-ce que l’explicabilité en IA et pourquoi est-elle cruciale?

L’explicabilité en Intelligence Artificielle (IA) est devenue un sujet majeur, notamment en raison de l’adoption croissante de technologies d’IA dans divers secteurs. Selon une étude publiée dans le journal Information Fusion, l’explicabilité en IA est un élément crucial pour le déploiement pratique de modèles d’IA à grande échelle.

Définition de l’explicabilité en IA

Avant de continuer, définissons l’explicabilité dans les systèmes d’IA. En effet, l’explicabilité réfère à la clarté avec laquelle un système d’IA peut expliquer ses décisions, actions et comportements à une audience donnée. Cette audience peut être composée de développeurs, d’utilisateurs finaux, ou même de régulateurs. L’explicabilité englobe plusieurs aspects tels que la transparence, l’interprétabilité et la responsabilité.

Contexte et importance des systèmes d’IA explicables

Dans le contexte actuel où l’IA est de plus en plus intégrée dans nos vies et nos entreprises, l’explicabilité prend une importance capitale. Les modèles d’IA, notamment ceux basés sur le Deep Learning et le Machine Learning, sont souvent perçus comme des « boîtes noires », produisant des résultats sans fournir d’explications claires sur la manière dont ces résultats ont été obtenus. Cette opacité peut entraîner des risques significatifs, notamment en termes d’éthique et de conformité réglementaire.

L’absence d’explicabilité peut également avoir des implications graves dans des domaines tels que la santé, la finance et la justice, où les décisions prises par les systèmes d’IA peuvent avoir des conséquences directes sur notre quotidien. Par conséquent, l’explicabilité n’est pas seulement une question technique, mais aussi une question éthique et sociale qui nécessite une attention immédiate.

L’importance de l’explicabilité des algorithmes dans l’IA pour les entreprises

Dans un contexte économique, l’absence d’explicabilité peut entraîner des risques significatifs. Elle peut causer des erreurs de traitement des données, nécessitant des retraitements coûteux et longs. De plus, une IA non explicite peut perpétuer des biais inhérents à ses données d’entraînement, générant ainsi des inexactitudes et des erreurs de jugement. Selon une étude publiée dans Information Fusion, l’explicabilité en IA est devenue une préoccupation majeure pour les entreprises et les chercheurs. Elle est considérée comme un élément clé pour établir la confiance et l’acceptation des systèmes d’IA par les utilisateurs.

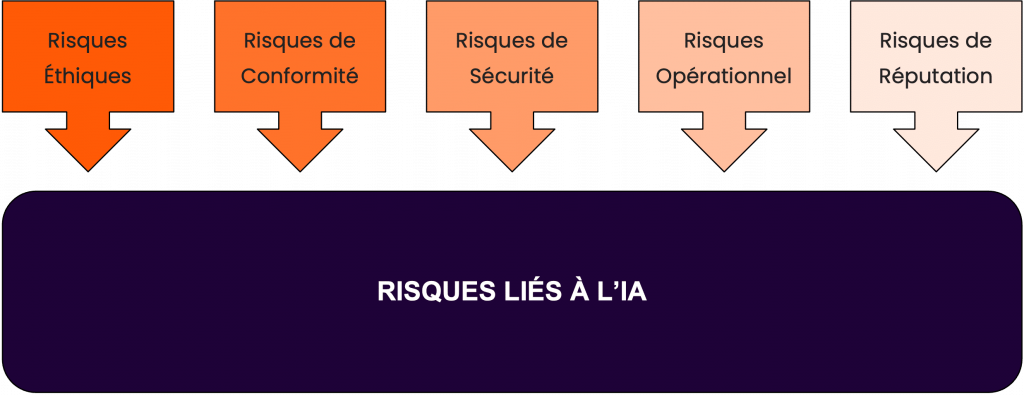

Types de risques liés à l’IA

L’IA présente plusieurs types de risques qui peuvent être classés en différentes catégories :

Risques Éthiques : Risques liés à la discrimination, aux biais et à l’inéquité. Une IA non explicite peut perpétuer ces problèmes sans que les utilisateurs en soient conscients.

Risques de Conformité : Risques liés au non-respect des réglementations en vigueur, comme le RGPD ou l’IA Act en Europe. Cela concerne notamment les sujets de KYC dans le secteur bancaire.

Risques de Sécurité : Risques liés aux cyberattaques, au vol de données et à la violation de la confidentialité.

Risques Opérationnels : Risques liés à la mauvaise performance ou aux erreurs de l’IA, qui peuvent avoir un impact direct sur les opérations de l’entreprise.

Risques de Réputation : Risques liés à la perception publique de l’entreprise, qui peut être affectée par les actions ou les décisions de l’IA.

Types d’explicabilité en IA : générative vs analytique

Comprendre l’IA Générative

L’IA générative, exploitant des algorithmes de Machine Learning, utilise des réseaux de neurones pour créer de nouvelles données qui sont basées sur les données d’entraînement. Cependant, ce processus est souvent opaque, ce qui rend leur explicabilité difficile. Selon une méta-étude sur l’IA explicative, l’opacité des modèles génératifs est l’un des défis majeurs à surmonter pour rendre l’IA plus compréhensible.

L’apport de l’IA analytique

Parallèlement, l‘IA analytique se focalise sur l’extraction d’informations pertinentes à partir de vastes ensembles de données. Elle est plus explicite car elle repose sur des règles et des critères définis pour interpréter les données. Une étude publiée dans « Proceedings of the AAAI Conference on Artificial Intelligence » souligne que l‘IA analytique offre une meilleure transparence et peut aider à éliminer les biais inhérents aux données.

La responsabilité des décisions en IA et l’explicabilité

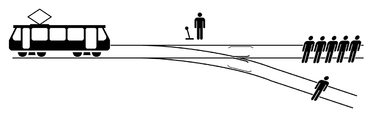

La question de l’éthique et de la responsabilité en IA est complexe mais essentielle. Les systèmes d’IA, de plus en plus intégrés dans notre quotidien, prennent des décisions ayant des conséquences significatives. Par exemple, en cas de danger, un système de voiture autonome doit-il privilégier la sécurité du passager ou celle des piétons? Cette question, connue sous le nom de « dilemme du tramway« , illustre parfaitement les défis éthiques que l’IA doit affronter. Encore plus depuis l’apparition des voitures autonomes en 2010.

La responsabilité des décisions de l’IA est également un sujet important. Qui est responsable lorsque l’IA commet une erreur ou prend une mauvaise décision? Est-ce le concepteur de l’IA? Le développeur en charge des règles algorithmiques ? L’utilisateur? Selon une étude publiée dans Applied AI Letters, l’explicabilité joue un rôle crucial pour attribuer la responsabilité de manière appropriée.

Étude de cas : Manutan

Manutan, leader européen du e-commerce BtoB spécialisé dans la distribution multicanale d’équipements pour les entreprises et les collectivités, souhaitait optimiser l’analyse de ses emails entrants. La mise en œuvre de notre IA analytique a changé la donne. Grâce à l’explicabilité de notre système, Manutan a pu comprendre comment l’IA catégorisait les emails, facilitant ainsi une meilleure gestion de la correspondance client. Xavier Laurent de Manutan a souligné la capacité de notre système à permettre des ajustements ciblés, qu’il a qualifiés de « petits coups de tournevis« . Cela a permis à Manutan d’apporter des corrections précises en cas d’erreur, améliorant constamment le service client.

Étude de cas : Saretec

Dans le secteur critique de l’expertise en assurance, Saretec cherchait à optimiser le traitement de ses nombreux emails entrants. La collaboration avec Golem.ai a inauguré une ère nouvelle, grâce à la solution InboxCare, explicable “by design”, permettant une intégration transparente et fiable dans le système existant de Saretec.

Alain Guede, DSI chez Saretec, a souligné comment cette initiative a « permis de réduire les tâches à faible valeur ajoutée et de renforcer notre efficacité opérationnelle« , un pas en avant significatif dans les secteurs à haut risque comme l’assurance, où la précision et la fiabilité sont primordiales.

Soulignant l’agilité du système, Killian Vermersch, CEO & Cofondateur de Golem.ai, a noté que « Grâce à l’explicabilité il est notamment très rapide de comprendre où l’IA se trompe et comment rectifier ses erreurs« . Cette explicabilité facilite les ajustements précis, cruciaux dans les secteurs à haut risque tels que l’assurance, la finance, et la défense, garantissant ainsi une meilleure gestion et une sécurisation renforcée. Cette collaboration est un témoignage de l’efficacité et de l’importance de l’explicabilité dans l’intégration de l’IA dans des domaines critiques.

Conclusion

L’explicabilité en IA est essentielle pour de nombreuses raisons. Elle favorise une meilleure compréhension des résultats obtenus, permet une amélioration continue, une responsabilité claire et un alignement éthique. Chez Golem.ai, nous comprenons l’importance de l’explicabilité et nous nous engageons à fournir des solutions d’IA explicables. Que vous soyez un DSI à la recherche d’une solution d’IA pour votre entreprise, ou un dirigeant d’entreprise soucieux de l’éthique et de la responsabilité en matière d’IA, Golem.ai est là pour vous aider.

Pour en savoir plus sur nos solutions d’IA, visitez notre page produit ou contactez notre service commercial pour prendre un rendez-vous.